【本文来自《ChatGPT之父等350余位专家高管联名警告:AI堪比疫情和核战,有灭绝人类的风险》评论区,标题为小编添加】

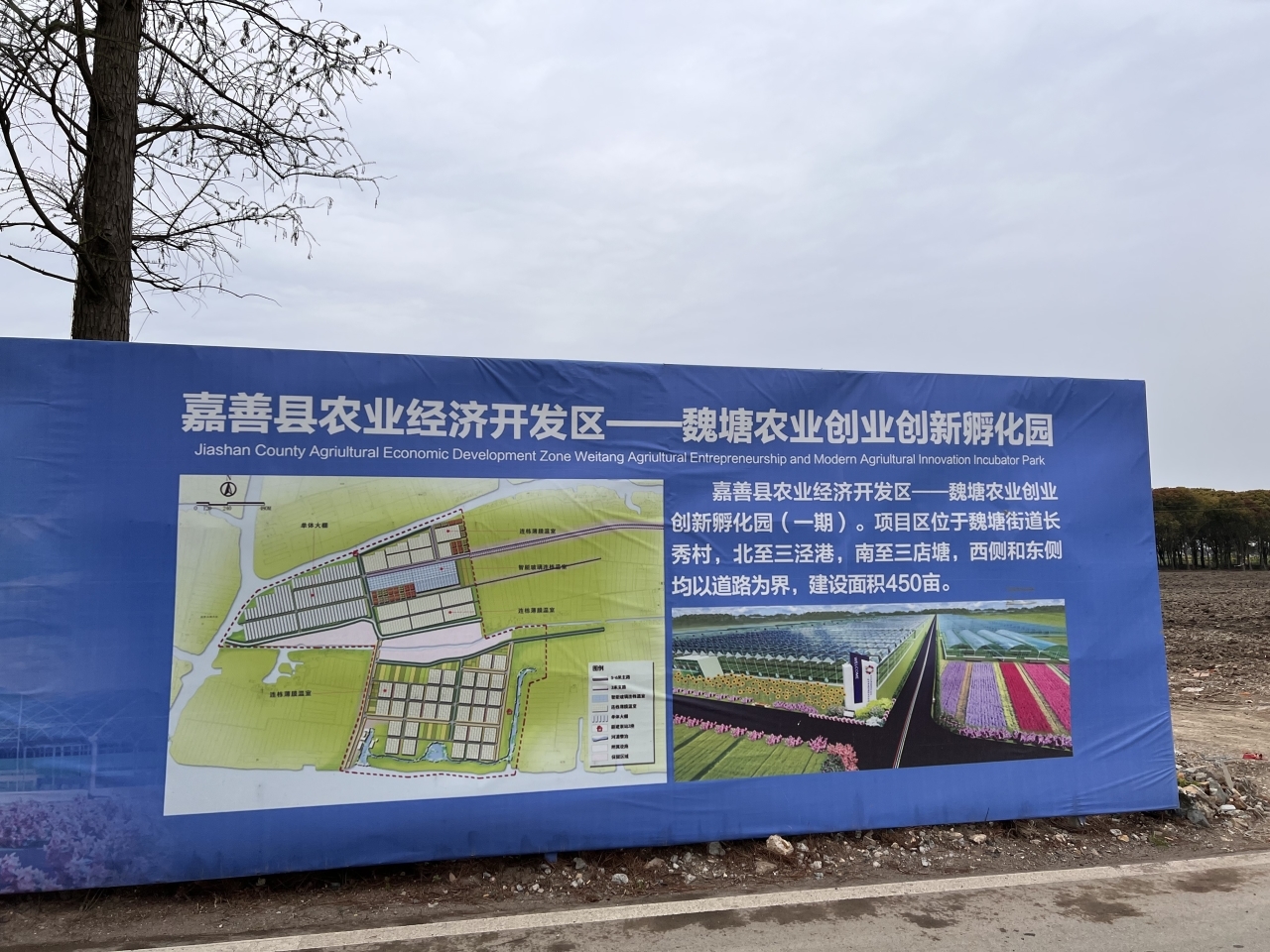

(相关资料图)

(相关资料图)

杞人忧天了,真正的人工智能还很远,目前的人工智能本质绝大部分就是大数据统计归纳,依托现在算力进步,暴力进行大量大数据模型训练统计归纳,说白了就是人类已有事务已有规则的统计归纳,对于全新的事务,没有训练过的模型,目前人工智能就是人工智障,所谓的深度学习,也不是人工智能有学习的能力,而是算法工程师会不断拿新的数据去标注新的模型,训练新的模型,把这个不断训练新的模型的过程叫做学习的能力,关键这个学习的过程是算法工程师参与的,不是人工智能自主的行为,人工智能仍然是执行算法模型特征匹配的角色,没有自主算法设计决策的成分在里面,真正的有危险的人工智能是要能自己思考的,有自主学习思考决策的能力,目前的人工智能不具备自主思考决策的能力,只是对已有的事务规则统计归纳,已有模型的特征匹配,想要达到自主思考决策的能力还很遥远

懒得烧脑了,引用以前的评论:

下一代工业革命:新能源、新材料、新计算、生命科学。。。

再往下走,我们就需要注意数学危机了,发展必然。而为了人类生存,我们也不得不主动容留数学危机、制造数学陷阱与逻辑炸弹。特别是应用于人工智能上,需要多层布设,而最底的那一层数学陷阱或逻辑炸弹的目标是时间,人工智能必须是有寿命的。。。

先不说人工智能真的诞生自主思想那么远的事(以网络体量和人力相比,人类所能接触的网络也仅是其表面界面而已),就光说现在或不远的未来,如果人工智能在战场上或其它应用场景失控,那么必须有东西能快速控制住它们,这必须放在它们的系统核心,而不是靠它们被动耗光电量。而再未来,发展到更高程度,想耗光电量都不可能。。。

如果说真的到了完全失控那一天,人类唯一能自救的大概就是主动发现或制造再下*代数学危机了。。。

应对人工智能设立一个人类存续危害标准,而根据这个标准建立一个全球协调机制,所有符合这个标准的都需要在联合国登记,并全球公示,哪怕是秘密项目也需要。当然准许秘密项目只公布一个虚假名称,标注“秘密项目”,但是只允许国家存在秘密项目,不允许其它机构存在秘密项目,多国合作也需要标示……到了人类危机时刻,哪怕知道数量和用排除法,都是有益的。。。

而国内也需要一个标准,在国内市场上市的产品只要触发标准,就必须事前、事中、变更都要注册、上报、审核……如果更进一步,哪怕不上市,只要立项,就要注册上报审核……

……,那能不能实现被观测对象的自我记录,地球生物和人类会不会是这种被隔离的观测对象,我们未来会不会继续延续创造这种可以实现自我记录的隔离的被观测对象,或者我们已经在创造了,而未来我们创造的被观测对象会继续创造它们的被观测对象……如果我们定位为0,那我们上边有1,2,3…,我们下边有-1,-2,-3…,如果这是坐标轴的纵轴,而横轴是我们由无智慧(…,-3,-2,-1)到有智慧(0,1,2,3…),或者有更复杂的坐标轴,怎么用数学方法理解这种假设???

……………………

其它比如各类型高危实验室、穷极法先发无限垄断、野心人群……

-

天天播报:京东带广告的店家是什么意思_店家是什么意思1、店家,旧时指旅店、酒馆、饭铺的主人或管事的人,就是我们现代说的老板,《水浒传》中描述:店家去里面

天天播报:京东带广告的店家是什么意思_店家是什么意思1、店家,旧时指旅店、酒馆、饭铺的主人或管事的人,就是我们现代说的老板,《水浒传》中描述:店家去里面 -

海口大致坡农产品加工产业园招商引资“新突破” 天天快看点商报全媒体讯(椰网 海拔新闻记者王辉通讯员王聘钊)近日,海口美兰区大致坡农产品加工产业园一期的三宗地

海口大致坡农产品加工产业园招商引资“新突破” 天天快看点商报全媒体讯(椰网 海拔新闻记者王辉通讯员王聘钊)近日,海口美兰区大致坡农产品加工产业园一期的三宗地 -

天天快资讯:复地与合肥签订战略合作框架协议 将共同设立100亿元产业基金群复地产发集团近日已与合肥市相关政府部门和在地企业签订战略合作框架协议,计划在生物医药产业、总部经济及

天天快资讯:复地与合肥签订战略合作框架协议 将共同设立100亿元产业基金群复地产发集团近日已与合肥市相关政府部门和在地企业签订战略合作框架协议,计划在生物医药产业、总部经济及 -

马斯克今晚抵达上海 将视察新款Model 3产线5月31日晚间,特斯拉CEO埃隆?马斯克(ElonMusk)按计划抵达上海。上海超级工厂新款Model3产线有望迎来马斯

马斯克今晚抵达上海 将视察新款Model 3产线5月31日晚间,特斯拉CEO埃隆?马斯克(ElonMusk)按计划抵达上海。上海超级工厂新款Model3产线有望迎来马斯 -

一位付费API工程师如何制造了推特今年第七次崩溃?-全球球精选大数据文摘出品作者:Caleb推特的“闹剧”还在继续。3月6日,当推特用户像平常那样打开APP后,却发现很多推

一位付费API工程师如何制造了推特今年第七次崩溃?-全球球精选大数据文摘出品作者:Caleb推特的“闹剧”还在继续。3月6日,当推特用户像平常那样打开APP后,却发现很多推

-

天天播报:京东带广告的店家是什么意思_店家是什么意思

2023-05-31 21:09:44

-

海口大致坡农产品加工产业园招商引资“新突破” 天天快看点

2023-05-31 20:31:33

-

天天快资讯:复地与合肥签订战略合作框架协议 将共同设立100亿元产业基金群

2023-05-31 20:35:53

-

马斯克今晚抵达上海 将视察新款Model 3产线

2023-05-31 20:33:22

-

一位付费API工程师如何制造了推特今年第七次崩溃?-全球球精选

2023-05-31 19:47:44