本文原创于微信公众号:差评 作者:差评君

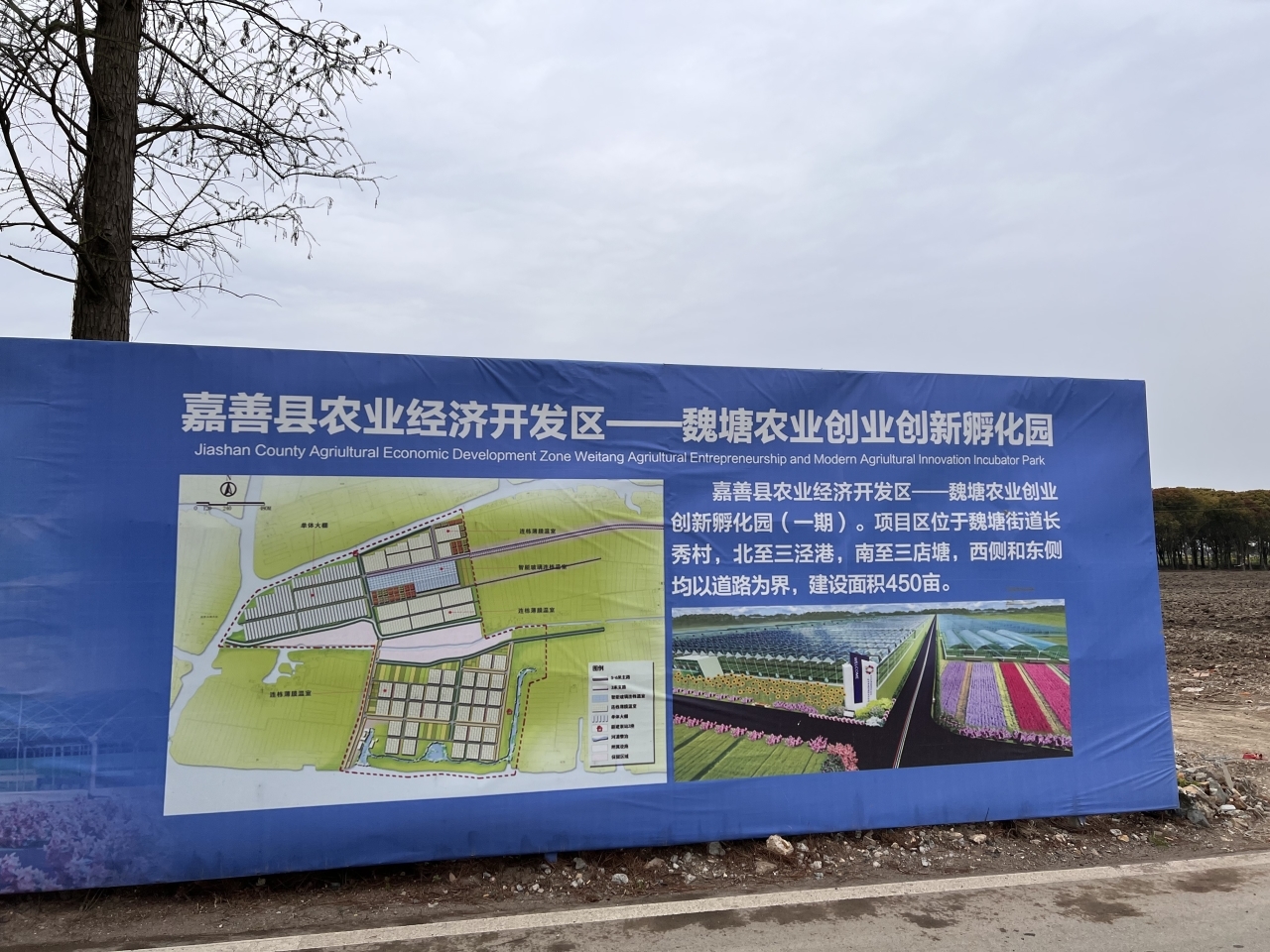

(资料图片)

(资料图片)

华语乐坛,难道要重生了?!

最近差评君我在刷B站视频的时候,突然发现出现在我推荐页上的老歌手们又多了起来。

这类视频大多是以唱歌为主,有周杰伦的,有孙燕姿的,林俊杰的,甚至还有丁真郭德纲什么的。

只不过在这些视频的标题里,都会带有一个“AI”标签。

这类视频不仅非常多,关键是它们的播放量都还不差。

AI邓丽君的一首《反方向的钟》,喜获50万+播放。

AI周杰伦的一首“日系新歌”《单相思》,也是获得了80万+的播放量。

而且曾经6年不发新专的杰伦,因为这个AI替身,在这一两个月里发的“新歌”的量,估摸着已经超过前十年发的量的总和了。。。

至于曾经的“冷门歌手孙燕姿”,更是靠着AI替身,以一首《下雨天》,荣获超83万的播放量。

而且,这个AI孙燕姿,各种各样的风格曲目都有,从流行到摇滚,就没有AI孙燕姿掌控不了的曲风。

哪曾想到,原本已经脱离歌坛很久的孙燕姿,到了2023年,自己居然靠着AI替身,再次火了一把。一下子从曾经那个“冷门歌手”,变成了“2023最火爆华语歌手”。

可能也是看着现在华语歌坛有点拉,就连相声界的郭老师,都来凑热闹了,直接来了一首《 a lot 》。

把相声的基本功,“说、学、逗、唱”中的“说唱”演绎的淋漓尽致。

匪帮说唱配上于谦和郭德纲老师的“匪帮梗”,整个视频立马就有了一种“德云社厂牌”的气质,还有网友在评论里戏称郭老师为“ GodGang ”。。。

整个形势,就好像要回到20几几年那会的华语乐坛大爆发时代。

如果说,现在的新四大天王,把华语乐坛整成了华语哥谭。

那这个 AI 替身,可是真的把华语乐坛曾经的一丝辉煌给重现了。

所以这类 AI 视频到底是个啥东西?为什么在这两个月的时间里突然就爆发了?

差评君我仔细研究了一下,最后得出结论,让AI华语乐坛出现爆发式生长的,离不开这么一个开源项目:

So-vits-svc。

So-vits-svc源于21年的另一个叫做Vits的开源项目。

Vits是一种语音合成方法。

简单来说,就是可以对人的声学特征进行模拟,然后就可以直接用文本生成你模拟好的语音。

这个Vits虽然开源的早,但它没火起来只有一个原因,就是对普通用户来说,太难用了。

由于是文本生成语音,首先就得对需要训练的语音进行文本标记,特别不巧的是,训练Vits的模型又需要大量的语料才能获得比较好的效果,这个数量大概在数千至上万条5-10秒左右的音频。

所以,Vits效果好是好,但愿意折腾它的普通用户也不多。

到了2022年,一位叫“Rcell”的B站用户在Vits的基础上,结合了soft-vc、VIsinger等一系列项目,So-vits-svc就此诞生。

和Vits不同的是,So-vits不能通过文本直接合成语音,而是需要一段原始音频,然后利用这个原始音频,拟合成你想要的人的音色。

不过So-vits在训练声学特征时,需要的训练数据也相对较少,最短十几分钟,就能训练出一个能用的模型了。

到了今年三月,这个So-vits的项目迭代到4.0版本,更加易用,效果更好,再加上很多UP自发整理的整合包,这才让B站的AI视频出现了大爆发的趋势。

那这个So-vits项目易用到了什么程度呢?

差评君这里给大家做一个演示。

咱们直接把差评君的嘴替,蛋不利多酱的配音拿来训练,首先这些音频要经过切片和预处理,方便训练。

一切准备完毕后,就可以开始训练需要的声学模型啦,直接点击文件里面的推理,整个训练过程就开始了

在训练完成后,就能得到这样的声学模型。

有了模型就可以对音频进行推理了,我们先准备一段咱们需要拟合的干音,在这里就是一段唱歌的声音。

然后按照提示输入数值,等待推理完成即可。

最后在/results里的.flac文件,就是咱们通过训练蛋蛋的模型拟合出来的声音了。

之后我还找到了一个叫d-id的网站,这是一个可以将输入文本或音频转化为嘴型动画的网站,直接把图片和音频上传,就能在短时间内生成符合音频信息的视频。

把音频和视频合成,制作就结束了,整个过程几乎涉及不到什么有难度的点。

给大家看看成品,虽然这个过程花费时间不多,但整体的唱歌效果也还行,除了这选的曲子有点一言难尽之外。。

其实使用别人的声音来唱歌也不是一件稀奇的事情。

B站的鬼畜视频大家应该都看过吧?

鬼畜视频和这类AI视频有个共同点,就是它们都是用别人的声音来调教音频从而达到唱歌的效果。

但是传统鬼畜的方式,制作过程繁杂,最后出来的效果也和个人调音技术有很大的关系。

而这类AI视频,制作流程不但简单,声音的拟合效果也只取决于你训练的模型的好坏。

那这一对比下来,别的先不说,鬼畜区以后不得被AI视频干爆啊?

在一些AI视频下面,甚至已经有些网友在评论区哭喊,调音鬼畜要被AI代替了。。。

但差评君在询问了B站小编后,发现其实现在很多人对AI类的视频并没有很大的担忧。

小编认为技术服务于创意,AI带来的生产力提升也是一件好事,单调的AI原词现在也就是图个新鲜劲,不会对鬼畜区造成长远的影响。

这类AI视频,虽然在声音的还原上,相比传统鬼畜有极大优势,但是在内容多样性上,却远远不如传统鬼畜的方式。

咱就以最近很火的鬼畜素材 “ 泰裤辣 ” 举例。

整段原视频不过几十秒,比较有梗的也就是这句“泰!裤!辣!”。

在传统鬼畜的制作流程中,只需要把音频截下来,然后对一些比较有梗的词语进行重组拼贴,再进行调音。

然后对上口型的画面,一个鬼畜视频就完成了。

但如果想要用AI来做视频的话,对这类素材,首先就是音频素材量不够,短短几十秒的音频素材,完全不足以支撑训练出声学特征。

其次就是无法还原“梗”,最有梗的这句“泰!裤!辣!”,AI拟声完全没办法保留素材的原味。

就算你能训练出声学模型,当你把声音拟合到这个干声上时,你所有的语气,唱调,歌词,都会变成和原始干声一样。

这就少了很多乐趣了。

我们再回过头来看看鬼畜区的大部分视频,很多鬼畜视频的素材也就是一小段比较有趣的对话,比如九转大肠,鸡汤来了还有华强买瓜。

这些短短几分钟的素材全都不足以支撑AI训练出声学模型,自然也就没人会拿这些素材去做AI鬼畜了。

能被拿来做AI训练的,一般都是拥有很多音频训练集的人物,比如一些主播、配音演员还有歌手。

那这些歌手和主播就能被替代嘛?

只能说,目前可能还很难,但未来,谁也说不准。

B站就有一位翻唱区的UP,自己把自己的声音练了一个AI模型出来。

在听了最终的效果之后,直呼被AI版的自己爆杀。

评论区的观众更是发出惊叹,本来以为AI最不能取代的就是艺术类了,结果,现在最可能被取代的,就是艺术类工作。。。

不过,差评君之所以说现在还比较难取代的原因,主要是因为,目前的AI还不能做到对声音的完全定制化。

比如歌手在唱歌的时候经常会有一些临时的歌词改编啊,转调啊等等,这些AI目前还无法做到。

而且AI视频还有一点致命的缺点,你想要用AI唱歌,你首先得拥有这首歌的干音。。。

这个干音要么你自己唱,要么有歌手自己放出来,要么靠自己慢慢去调音,但这么一来,这些歌不还是人唱的嘛。。。

另外,AI工具潜藏着的使用安全问题,可能也会在日后让人们限制它的使用范围,由于这类AI工具简单易用,这也就意味着它降低了某些人利用这些软件做坏事的门槛。

在软件的命令行界面,从作者为了规范责任,写了这么一大串使用细则来看就知道,他们是真的怕!

你想想看,只要获取了你数十分钟的音频录音,我就能通过这个软件来模拟出你说话的声音。

那么通过这种方式来进行电信诈骗的话,可信度就提升了很多,毕竟再怎么防,也很难会想到自己的身边熟人的声音,居然是用AI合成的。

不过工具毕竟只是工具,有人拿它来电信诈骗,也有人会拿它来纪念亲人。

而且这类的视频也已经不少了,许多UP自己通过AI技术把已故艺术家们“复活”,比如这个使用AI技术让相声大师马三立来讲新相声的视频。

在评论区里有不少人听着听着,就流泪了。

感慨科技就应该在这个方向上使用。

还有UP,因为想念自己已故的奶奶,于是通过这种方式“复活”了她。

和自己的奶奶进行了一个隔空对话。

在AI邓丽君的唱歌视频下面,也有很多人对这种数字生命表达了感慨。

从嘲笑,到理解到爱上,最后成为数字生命。

这种种例子,不免让人感慨,技术不同的使用方式,带给人的是不同的体验。

随着AI技术的发展,我们可以大胆畅想,在不远的将来,或许我们也能拥有这样的数字生命,把已故的亲人保留下来,哪怕只是和他对上几句话,那也足够慰藉了。

图片、资料来源:

bilibili

Github

-

坐骨神经损伤怎么治疗最好_坐骨神经损伤怎么治疗1、问题分析:坐骨神经痛建议多运动,不要老坐着。2、运动方法有,交替直腿上抬运动,踏自行车运动,正坐举

坐骨神经损伤怎么治疗最好_坐骨神经损伤怎么治疗1、问题分析:坐骨神经痛建议多运动,不要老坐着。2、运动方法有,交替直腿上抬运动,踏自行车运动,正坐举 -

上市券商去年“百亿净利俱乐部”减员至3家 仅方正、信达盈利增加-世界观焦点虽然去年营收规模超过百亿的上市券商仍有16家,但其中仅有2家营收规模出现同比增加,且增幅均不大。虽然上

上市券商去年“百亿净利俱乐部”减员至3家 仅方正、信达盈利增加-世界观焦点虽然去年营收规模超过百亿的上市券商仍有16家,但其中仅有2家营收规模出现同比增加,且增幅均不大。虽然上 -

上海华瑞银行2022年报发布:自营发力 数字化业务逆势增长-世界最新根据年报,2022年受各种外部环境变化的影响,该行营收、净利润有所下降,但拨备计提较为充足,流动性保持合

上海华瑞银行2022年报发布:自营发力 数字化业务逆势增长-世界最新根据年报,2022年受各种外部环境变化的影响,该行营收、净利润有所下降,但拨备计提较为充足,流动性保持合 -

环球观天下!河南工业职业技术学院2022分数线是多少 各省录取最低位次2022年河南工业职业技术学院在甘肃理科的最低录取分数为160分,对应录取位次为112687。河南工业职业技术学

环球观天下!河南工业职业技术学院2022分数线是多少 各省录取最低位次2022年河南工业职业技术学院在甘肃理科的最低录取分数为160分,对应录取位次为112687。河南工业职业技术学 -

同比增长210% 岚图汽车4月交付3339辆-全球速递同比增长210%岚图汽车4月交付3339辆

同比增长210% 岚图汽车4月交付3339辆-全球速递同比增长210%岚图汽车4月交付3339辆

-

坐骨神经损伤怎么治疗最好_坐骨神经损伤怎么治疗

2023-05-01 18:43:20

-

上市券商去年“百亿净利俱乐部”减员至3家 仅方正、信达盈利增加-世界观焦点

2023-05-01 18:33:59

-

上海华瑞银行2022年报发布:自营发力 数字化业务逆势增长-世界最新

2023-05-01 18:27:02

-

环球观天下!河南工业职业技术学院2022分数线是多少 各省录取最低位次

2023-05-01 17:42:13

-

同比增长210% 岚图汽车4月交付3339辆-全球速递

2023-05-01 16:46:36